vscode continue调用ollama远程配置文件

远程计算机部署ollama模型后,在终端用vscode调用,部署还挺简单的,两条命令就部署完了,然后改一下监听端口就能被远程访问了,但是在vscode调用的时候有一些小阻碍

试了半天,查了半天,原来是apiBase配错了写成了小写的apibase,B一定要大写

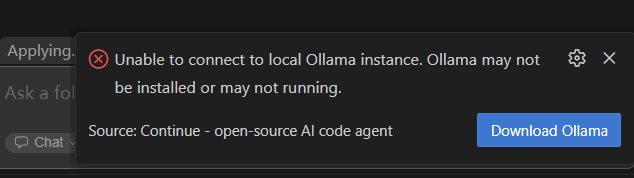

不然就会提示下面的内容

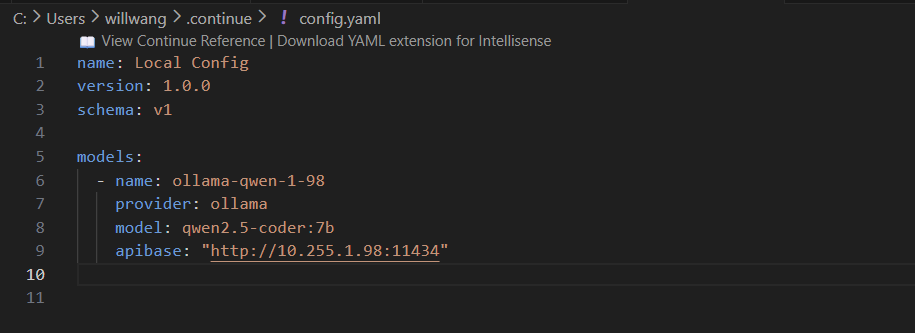

name: Local Config

version: 1.0.0

schema: v1

models:

- name: ollama-qwen-1-98

apiBase: "http://10.255.1.98:11434"

provider: ollama

model: qwen2.5-coder:7b

总之最后的步骤:

- 服务端部署ollama

- vscode安装continue

- 配置continue的config.yaml